The New York Times v. OpenAI: справа, що може змінити правила гри для всього AI-бізнесу

Микола Карчевський, 27.11.2025

У США існує доктрина Fair Use — «добросовісного використання». Вона дозволяє використовувати захищені авторським правом матеріали без згоди автора, якщо таке використання:

🔹є трансформативним (створює нову цінність, а не копіює оригінал)

🔹не шкодить ринку первинного твору

🔹стосується «розумного» обсягу

🔹має характер, що служить суспільним інтересам

Позов The New York Times v. OpenAI та Microsoft був поданий 27 грудня 2023 року, його розгляд триває. Спір стосується використання захищених авторським правом творів для тренування моделей ШІ.

📰 The New York Times стверджує:

– матеріали видання використовувалися для навчання моделей без дозволу;

– моделі іноді відтворюють фрагменти текстів майже дослівно;

– це шкодить ринку оригінального контенту та підриває економіку журналістики.

🤖 OpenAI відповідає:

– навчання моделей це трансформативне використання, яке підпадає під Fair Use;

– моделі не зберігають тексти у дослівному вигляді, а «вчаться» узагальнювати структури мови;

– без можливості навчатися на великому корпусі текстів сучасний ШІ взагалі не працюватиме.

🧭 Чому ця справа важлива

Рішення суду визначить:

– чи можна тренувати ШІ на відкритих матеріалах без ліцензії,

– як виглядатимуть угоди між медіа та AI-компаніями,

– які витрати доведеться закладати в розробку моделей у майбутньому та, відповідно, вкладати у вартість підписки,

– чи стане тренування ШІ привілеєм великих корпорацій, які здатні купувати доступ до контенту.

🚀 Які зміни варто очікувати

З’являться нові ринки даних – каталоги контенту спеціально для тренування ШІ. Держави будуть змушені актуалізувати законодавство авторське право в контексті машинного навчання.

📚Всі документи по справі: https://www.courtlistener.com/docket/68117049/the-new-york-times-company-v-microsoft-corporation/

Детальний аналіз:

📕Audrey Pope NYT v. OpenAI: The Times’s About‑Face. Harvard Law Review Blog. https://chatgpt.com/g/g-p-690f7a828bd88191b660686528777717-ai-kvadrat/c/691c969e-0414-8330-8007-1ee5e7008319

📗Stina Teilmann-Lock, Andrej Savin, Beyond the AI-copyright wars: towards European dataset law?, Computer Law & Security Review, Volume 58, 2025, https://doi.org/10.1016/j.clsr.2025.106190.

📙Chesterman, Simon, Good Models Borrow, Great Models Steal: Intellectual Property Rights and Generative AI (January 13, 2024). NUS Law Working Paper No. 2023/025; Policy & Society (2024), puae006, https://doi.org/10.1093/polsoc/puae006, Available at SSRN: https://ssrn.com/abstract=4590006

Світ змінився: від “небезпечного” до “несправедливого”. ШІ – грає ключову роль

Микола Карчевський, 23.11.2025

✍️Giuseppe Primiero у статті “Justice at the Core of a New AI Paradigm” для Harvard Data Science Review пропонує подивитися на штучний інтелект з нового ракурсу. Ми більше не живемо у небезпечному світі, де головне – уникнути технічних збоїв. Ми живемо у несправедливому світі, де алгоритми можуть відтворювати й підсилювати соціальні нерівності.

🌍 Перехід від «safety-critical» → до «justice-critical»

Традиційно технології оцінювали за критерієм безпеки: чи працює коректно, чи відповідає результат технічним характеристикам.

ШІ потребує іншої оцінки. Тепер ключове питання не: “Чи безпечний ШІ?”. Значно важливіше: 👉 “Чи справедливий ШІ?”

Primiero наголошує: ML-системи не просто аналізують дані – вони спадкують соціальні нерівності. У результаті виникає:

📍algorithmic inequality – алгоритми відтворюють соціальну нерівність і роблять її “автоматизованою”;

📍technological injustice – коли технологія працює “правильно”, але несправедливо, системно шкодить соціальним групам;

📍epistemic injustice – виключення людей з процесу формування знання про них, алгоритм «знає про людину більше, ніж вона дозволяє».

Алгоритм може працювати правильно технічно, але соціально – неправильно.

🛠 Як цього уникнути? “Affirmative action for technology design”, “care-based AI”

Автор пропонує змінити сам підхід до створення ШІ. Недостатньо “не дискримінувати”.

Треба створювати технології, які виправляють нерівність (affirmative action у дизайні технологій).

Етика турботи у ШІ (care-based AI). Технології – не нейтральні. Вони завжди вбудовані у соціальний контекст і формують його. Системи мають враховувати наслідки для реальних людей, не лише виявляти упередження, а й виправляти їх

Primiero пропонує концепцію: 📍 corrective abduction – здатність системи не просто фіксувати несправедливість, а шукати найкраще пояснення й генерувати корективи.

Повний текст статті: https://hdsr.mitpress.mit.edu/pub/ehs9dr1l/release/1?readingCollection=4a1a4763

👉 Коментар: Стаття Giuseppe Primiero є відповіддю на роботу Sabina Leonelli про Environmental Intelligence. Згадували цю роботу минулого тижня. Вона продовжує спроби зміни системи координат для оцінки соціальних наслідків ШІ. Дискримінація у соціальних застосунках ШІ очевидна. Дослідники пропонують не мінімізувати наслідки роботи алгоритмів, а визначати інакше задачу створення ШІ.

За логікою наступний крок – зміна регуляцій у бік більших вимог для попередження несправедливого використання. Водночас, в Європі спостерігається інший тренд: Європейською Комісією оголошено пропозиції “Digital Omnibus” які, містить послаблення ключових норм GDPR (Загального регламенту про захист даних) та AI Act (Закону про штучний інтелект). Ключова причина таких змін – бізнес інтереси.

Це підводить до ширшого питання: чи можуть співіснувати капітал і справедливість у сфері ШІ?

Бізнес рухає швидкість, конкуренція та постійне масштабування. Суспільство потребує іншого: прозорості, відповідальності та контролю за наслідками. Ця дискусія має тривалу історію. Буде цікаво як ШІ змінить/не змінить її.

Гаррі Каспаров та Deep Blue

Микола Карчевський, 20.11.2025

Поразка чемпіона світу з шахів Гаррі Каспарова від комп’ютера Deep Blue у 1997 році стала символом перемоги машин. Deep Blue переміг завдяки обчислювальній потужності. Він оцінював мільйони ходів за секунду. Проте Гаррі Каспаров згадував, що піонери ШІ були розчаровані, адже мріяли про машину, що ДУМАЄ як людина.

🤝 Шахи нового рівня

Дійсно цікаві події почалися коли з’явилася ідея «людина + машина». Каспаров започаткував “Advanced Chess” – гру, де обидва гравці використовують комп’ютери.

💻Комп’ютер взяв на себе тактичні розрахунки та запобігання помилкам.

🤔Людина зосереджувалася на стратегічному плануванні та креативних ідеях.

Результат: аматори, які вміло організували використання комп’ютерів, змогли перемогти сильних гросмейстерів з потужнішими машинами.

❗️Слабка людина + машина + кращий процес взаємодії виявилася ефективнішою ніж сильний комп’ютер сам по собі і, що більш примітно, ефективнішою, ніж сильна людина + машина + гірший процес.

ШІ – інструмент, який відкриває безпрецедентні можливості. Але справжній результат з’являється там, де інтуїція та креативність людини доповнена обчислювальною потужністю ШІ:)

Повний текст історії: https://www.chess-iecc.com/journaltxt/rankandfile01.pdf

Справа State v. Loomis (2016)

Микола Карчевський, 19.11.2025

Цю справу найчастіше згадують в контексті непрозорості алгоритмів ШІ, так званої проблеми “black box”.

⚖️Рішення було прийнято Верховним судом штату Вісконсин у липні 2016 року. Обвинувачений, Ерік Луміс (Eric Loomis), оскаржував свій вирок, посилаючись на те, що суддя під час винесення вироку використовував оцінку ризику рецидиву, згенеровану алгоритмом COMPAS (Correctional Offender Management Profiling for Alternative Sanctions). Луміс стверджував, що цей алгоритм, його внутрішня логіка та формула розрахунку ризику належать приватній компанії та не були розкриті для перевірки ні захисту, ні суду

🔍 По суті

Суд визнав, що використання звіту COMPAS під час винесення вироку не порушує права обвинуваченого на належну правову процедуру (due process).

Суд не визнав алгоритм COMPAS обов’язковим та вказав, що:

оцінка COMPAS є лише одним з багатьох факторів, і суддя не може виносити вирок, покладаючись виключно на неї.

Звіти COMPAS повинні містити письмове застереження про їхні обмеження, зокрема про те, що методологія алгоритму є комерційною таємницею (тобто не розкривається), і що оцінки базуються на групових даних, а не на індивідуальній особі.

Обвинувачений має право спростувати або пояснити будь-яку інформацію, що використовується в оцінці.

Таким чином, суд дозволив використовувати інструмент, але зобов’язав суддів ставитися до нього критично і визнавати його допоміжний, а не вирішальний характер.

❗️Важлива деталь

Рішенню суду передувало розслідування команди ProPublica під назвою “Machine Bias”, воно було оприлюднено у травні 2016 року. Розслідування виявило, що алгоритм COMPAS мав расову упередженість: він частіше помилково класифікував темношкірих обвинувачених як осіб із високим ризиком рецидиву, ніж білих обвинувачених, навіть якщо вони не скоювали нових злочинів. Було досліджено 7000 алгоритмічних оцінок (!)

Рішення суду у справі Loomis безпосередньо посилається на висновки ProPublica та інші дослідження, які ставлять під сумнів точність і справедливість алгоритму COMPAS.

📕Посилання на дослідження: https://www.propublica.org/article/machine-bias-risk-assessments-in-criminal-sentencing

📖Детальний аналіз судового рішення у Harvard Law Review

1️⃣State v. Loomis. Harvard Law Review. URL: https://harvardlawreview.org/print/vol-130/state-v-loomis/

📚Наукові публікації

2️⃣Ellora Israni, Algorithmic Due Process: Mistaken Accountability and Attribution in State v. Loomis. Harvard Journal of Law & Technology Digest. URL: https://jolt.law.harvard.edu/digest/algorithmic-due-process-mistaken-accountability-and-attribution-in-state-v-loomis-1

3️⃣Alexandra Taylor, Data and Discretion: Why We Should Exercise Caution Around Using the COMPAS Algorithm in Court. Stanford Rewired. URL: https://stanfordrewired.com/post/data-and-discretion/

4️⃣Katherine Freeman, Algorithmic Injustice: How the Wisconsin Supreme Court Failed to Protect Due Process Rights in State v. Loomis, 18 N.C. J.L. & Tech. 75 (2018). URL: https://scholarship.law.unc.edu/ncjolt/vol18/iss5/3

5️⃣Liu, Han-Wei & Lin, Ching-Fu & Chen, Yu-Jie. (2019). Beyond State v. Loomis: Artificial Intelligence, Government Algorithmization, and Accountability. International Journal of Law and Information Technology. URL: https://www.researchgate.net/publication/332457303_Beyond_State_v_Loomis_Artificial_Intelligence_Government_Algorithmization_and_Accountability

💡 Час переосмислити Штучний Інтелект. Environmental Intelligence 🤖

Микола Карчевський, 17.11.2025

На цьому наполягає Sabina Leonelli у статті “Environmental Intelligence: Redefining the Philosophical Premises of AI” (Harvard Data Science Review, 2025)

🌐Повний текст – https://hdsr.mitpress.mit.edu/pub/mx9vpa0b/release/2?readingCollection=4a1a4763

Традиційне розуміння ШІ зосереджене на антропоцентричній, але бездушній ефективності – ідеї перевершити людські обмеження та автоматизувати мислення.

Це бачення здається логічним, але має небезпечні наслідки:

⚠️ Екзистенційні ризики: прагнення до повного контролю над природою загрожує самознищенням людства.

⚠️ Соціальна нерівність: розвиток енергоємних технологій служить вузькому колу багатих і впливових.

⚠️ Нестійкість: культ прогресу і продуктивності відриває інновації від контексту, надійності та стійкості.

🌿 Відповідь – Environmental Intelligence (Екологічний Інтелект, EI). Як зазначає Сабіна Леонеллі, ЕІ -це не технологія, а нове мислення про роль технологій у житті планети.

🧠 ЕІ – це підхід, який розглядає інтелект не як ізольований продукт людського мозку, а як результат взаємодії людей, нелюдських організмів і середовища. Його мета – підтримувати і розвивати життя на Землі, а не просто підвищувати ефективність процесів.

🌍 Переваги ЕІ над традиційним ШІ:

Ставить у центр не конкуренцію з природою, а взаємодію і співіснування.

Спрямовує інновації на суспільний інтерес і планетарне здоров’я.

Наголошує на різноманітності та справедливості, а не на стандартизації.

Вимагає відповідальності та співчуття, а не лише раціональності.

👉Коментар. Можливо хтось згадає класика та скаже: “Так це ж вже було…”. Дискурс про sustainable development справді проглядається. Менше з тим, стаття цікава демонстрацією очевидних проблем поширеного та найбільш визнаного розуміння ШІ. Питання поглиблення цифрового розриву через доступність сучасних технологій обробки інформації є реальним. Тому бачити потенціал нових конфліктів, які можуть охопити всю планету, через розвиток ШІ в актуальній парадигмі цілком правильно. Важливим є й акцент на розподілену природу інтелекту. Нещодавно проходили це з фінансами. Потреба у фінансових інструментах, позбавлених державного контролю, була реалізована у децентралізованих криптовалютах. Як добре відомо, зберігання даних про їх транзакції є розподіленим. Отже все помітнішою стає потреба у подібній до віртуальних активів схемі функціонування ШІ. Розподілений ШІ варто розглядати як технологію позбавлену корпоративного контролю. Думаю побачимо ще не одну статтю на цю тему.

💡 Планаризація

Микола Карчевський, 15.11.2025

📖 У редакційній статті Xiao-Li Meng “Writing With AI, About AI, and By AI”, опублікованій у Harvard Data Science Review (Fall 2025), порушено одну з найменш обговорюваних, але надзвичайно важливих проблем епохи генеративного ШІ – спрощення складного, або, як називає це автор, planarization.

🤖 ШІ перетворює багатовимірну реальність на пласку поверхню зрозумілих, але неточних узагальнень. Він стирає межі між фактом і припущенням, між контекстом і результатом, між “попереднім” і “доведеним”.

🎭 У підсумку ми отримуємо красиві тексти, з яких зникає саме те, заради чого існує наука — сумнів, нюанс і невизначеність.

🎓 На думку Менга, це не лише технічне, а передусім педагогічне питання.

Якщо штучний інтелект спрощує світ, то освіта має навчати долати спрощення.

💬 «… як ми можемо підготувати студентів до зустрічі з такими явищами зі здоровим скептицизмом та вкоріненими звичками перевірки та валідації, оскільки ми глибше занурюємося в еру генеративного штучного інтелекту – еру, де навіть власні очі можуть нас обманювати?»

🧩 Отже, треба не лише працювати з моделями, а й ставити під сумнів результати, шукати, що саме ШІ “викинув” зі складної системи, і відновлювати багатовимірність – контекст, джерела, межі методів.

🗨 Коментар. Викриваючи важливу проблему, автор не закликає обмежити чи заборонити використання ШІ. Не пропонує регулювати його використання численними наказами або інструкціями. 👨🏫 Сяо-Лі Менг – професор статистики Гарвардського університету імені Віппла В. Н. Джонса — виходить із прагматичного припущення: розвиток технології не можна зупинити. Тому він пропонує ще один вимір критичної оцінки результатів роботи ШІ – тест на спрощення 🧠.

https://hdsr.mitpress.mit.edu/pub/9egfxxqj/release/2?readingCollection=4a1a4763

Мрія про AGI (загальний ШІ) стає теорією змови 🤖🌀.

Микола Карчевський, 12.11.2025

Так вважає Will Douglas Heaven автор статті «How AGI became the most consequential conspiracy theory of our time» (MIT Technology Review).

🔹Загальний або “сильний” ШІ це ГІПОТЕТИЧНИЙ пристрій, який здатен мислити як людина або перевищує можливості інтелектуальні можливості людини.

Стаття розкриває, як дискурс навколо AGI почав нагадувати теорію змови.

🧠 Ключові ідеї

📍AGI часто подається як «скоро станеться», «все зміниться» — але при цьому дефініція розмазана, часові рамки невизначені.

📍AGI використовують не лише як науковий проект, а як маркетинговий та інвестиційний аргумент: великі ресурси, великі обіцянки.

📍Очікування створюють уявну необхідність соціальних, технологічних і регуляторних кроків – навіть якщо самої технології AGI не існує.

Автор закликає: ставте питання «Що ми маємо насправді?», «Які докази?», «Чи це не технологічний міф?».

💡 Коментар: в умовах агресивного інформаційного середовища міркувати про фактичне застосування ШІ, справжні можливості та ризики слід починати з послідовного встановлення реального рівня актуальних технологій. Варто звернути увагу на таку складову сучасної освіти як AI Literacy – грамотність у сфері штучного інтелекту «набір компетенцій, що дозволяє людям критично оцінювати технології штучного інтелекту; ефективно спілкуватися та співпрацювати зі штучним інтелектом; а також використовувати штучний інтелект як інструмент» (Long & Magerko, 2020)

Мав честь виступити на науково-практичній конференції

Микола Карчевський, 9.11.2025

5.11.2025 взяв участь у роботі конференції «Україна в умовах соціальної та цифрової трансформації: теоретичні моделі правового регулювання штучного інтелекту», організованій ДНУ «Інститут інформації, безпеки і права НАПрН України»

📚 Моя доповідь – трирівнева модель правового регулювання ШІ, мета-рівень, стратегічний і тактичний рівні, теоретична рамка для побудови цілісної системи правового регулювання.

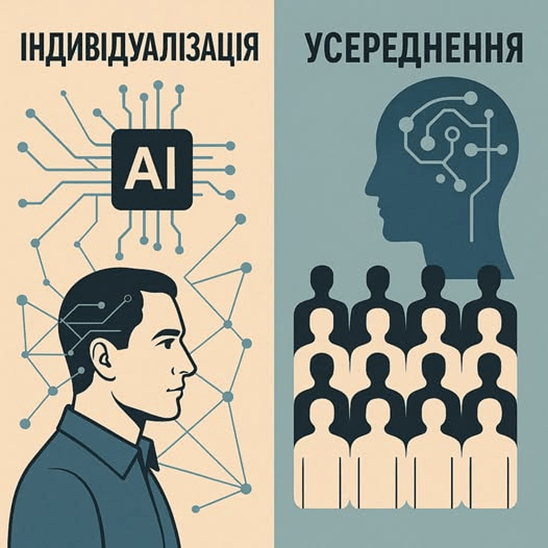

💡 Ключовий акцент – фундаментальний конфлікт мета-рівня між індивідуалізацією (право як гарантія унікальності людини) та алгоритмічним усередненням (ШІ як статистичний механізм).

ШІ може або забезпечити індивідуалізацію потреб людини, або – у протилежному сценарії – зводити її до “середнього профілю”. Останній варіант і становить ризик, є центральним викликом епохи алгоритмізації.

🧭 Моє твердження: мета-рівень правового регулювання ШІ має забезпечувати максимальну індивідуалізацію прогнозів на основі великих даних – це єдина гарантія збереження гідності та свободи вибору людини в цифрову добу.

Дякую організаторам та всім учасникам конференції за цікаву дискусію та спільне осмислення майбутнього права в епоху ШІ!

P.S. Малюнок створив з ШІ

Коли технологія може читати ваші думки: нова загроза для правосуддя

Микола Карчевський, 8.11.2025

Уявіть собі технологію, яка може “почути” те, що ви промовляєте в думках. Це вже не фантастика – це BCI-системи (Brain-Computer Interface)

Коли Ви уявляєте, що щось говорите (навіть не ворушачи губами), ваш мозок генерує специфічні електричні сигнали. BCI-системи зчитують ці сигнали, а штучний інтелект намагається “декодувати” ваші думки в слова.

🤔Спочатку ці технології розроблялися для людей з розладами мовлення. Розвиток таких технологій вимагає мислити про нові ризики.

❗️Право не свідчити проти себе може втратити сенс, коли думки можна буде “витягнути” без вашої згоди.

❗️Право на приватність порушується в найглибший спосіб – доступ до думок.

❗️Під загрозою сама ідея свободи думок.

Докладніше у статті

John, Angel Mary, M. U. Aiswarya, and Jerrin Thomas Panachakel. “Ethical challenges of using artificial intelligence in judiciary.” 2023 IEEE International Conference on Metrology for eXtended Reality, Artificial Intelligence and Neural Engineering (MetroXRAINE). IEEE, 2023.

https://arxiv.org/abs/2504.19284

Коментар: Нові технології неминуче створюють нові ризики. Реальну небезпеку BCI-систем для кримінальної юстиції можна буде оцінити після більш повного розуміння рівня розвитку технології, перспектив її вдосконалення та масштабування подібних рішень. Поки що це скоріше історія-попередження про необхідність передбачати етичні виклики технологічного виміру правосуддя, аніж про конкретну загрозу тут і зараз. Але саме зараз – найкращий час для суспільної дискусії про межі допустимого, поки технологія ще не стала повсякденною реальністю судових процесів.